Muchos servidores trabajan al 20–30% de uso mientras otros se quedan sin recursos. Esa ineficiencia y el riesgo al probar cambios motivan la virtualización moderna. Con ella, un equipo físico aloja varios sistemas aislados que no se interfieren. Así aprovechas mejor hardware y controlas fallos sin duplicar máquinas ni presupuestos. Todo ocurre mediante software especializado que reparte CPU, memoria, disco y red.

Aquí entenderás qué es la virtualización y para qué se utiliza, sin rodeos técnicos. Verás máquinas virtuales y contenedores, cuándo elegirlas y qué papel juegan los hipervisores. Explicaremos aislamiento, recursos compartidos y cómo encajan en servidores, escritorio, red y almacenamiento. También conectaremos estas bases con cloud computing y modelos de despliegue elásticos y seguros.

Al terminar, distinguirás tipos de virtualización, sus casos de uso y límites razonables. Podrás valorar impacto en rendimiento, costes y seguridad con ejemplos claros y lenguaje directo. No hay guías de instalación: solo contexto útil para decidir y conversar con tu equipo.

Definición de virtualización y principios de funcionamiento

La virtualización es una forma de usar un mismo equipo físico para ejecutar varios sistemas aislados. Cada uno funciona como si tuviera su propio ordenador, con su sistema y sus aplicaciones. El objetivo es aprovechar mejor los recursos y ganar flexibilidad sin multiplicar el hardware.

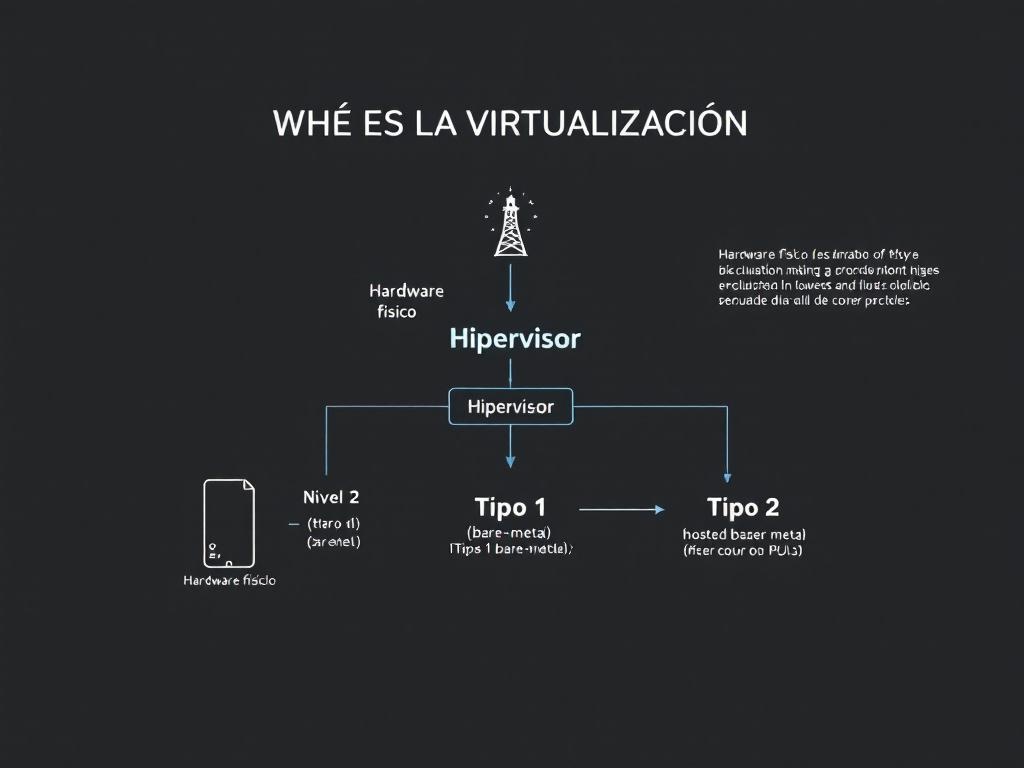

Para lograrlo se usa un componente clave: el hipervisor. Este software reparte de forma controlada la CPU, la memoria, el almacenamiento y la red entre las distintas instancias. También impone reglas para que una no interfiera en la otra.

Imagina un edificio con varias viviendas. El hipervisor sería la administración del edificio que asigna luz, agua y normas a cada piso. Así, cada “vivienda” puede organizarse sin molestar a las demás.

En esta capa se crean las máquinas virtuales (VM). Cada VM tiene su propio sistema operativo invitado y se cree instalada en un equipo real. En realidad, usa recursos virtuales que el hipervisor traduce al hardware físico.

Este mecanismo descansa en dos ideas centrales. La primera es el aislamiento: fallos o cambios dentro de una VM no afectan a las otras. La segunda es la abstracción: las VMs ven dispositivos virtuales estándar, aunque debajo el hardware sea distinto.

Hay dos enfoques de hipervisor. Un hipervisor tipo 1 corre directamente sobre el hardware y se orienta a centros de datos y producción. Un hipervisor tipo 2 se ejecuta como una aplicación sobre un sistema operativo anfitrión, muy útil para portátiles y laboratorios.

El intercambio por esta capa extra es una pequeña carga de trabajo adicional, conocida como overhead. En la práctica, los hipervisores modernos, las colas de entrada/salida eficientes y los controladores paravirtualizados reducen ese coste. Además, las CPU actuales incluyen instrucciones especiales de aceleración por hardware para que las VMs rindan cerca del nivel nativo.

Las máquinas virtuales no son la única opción. La virtualización a nivel de sistema operativo (contenedores) comparte el kernel del anfitrión para aislar procesos y dependencias. Es más ligera y arranca en segundos, aunque ofrece un aislamiento diferente al de una VM completa.

En ambos casos, el patrón es el mismo: empaquetar lo necesario para ejecutar un servicio en una unidad controlada. Con VMs, esa unidad es un sistema completo. Con contenedores, esa unidad es una aplicación con su entorno mínimo.

Este desacoplamiento aporta varias ventajas inmediatas. Puedes consolidar servidores, crear entornos de pruebas desechables y mover cargas a otra máquina sin reinstalarlo todo. También facilita estrategias de recuperación ante desastres mediante imágenes y snapshots que capturan estados en un punto del tiempo.

En cuanto a la gestión, es habitual combinar el hipervisor con herramientas de orquestación. Estas asignan recursos, automatizan despliegues, definen redes virtuales y equilibran cargas. El resultado es una infraestructura más ordenada y fácil de escalar.

Conviene entender sus límites para decidir bien. El overhead puede notarse en tareas muy sensibles a la latencia o con E/S intensiva. Además, la virtualización introduce más piezas a vigilar: hosts, redes virtuales, almacenamiento y políticas de seguridad.

Para mitigar estos retos se aplican buenas prácticas sencillas. Usar drivers paravirtualizados en red y disco, almacenar datos en volúmenes rápidos y ajustar cuotas de CPU y memoria ayuda a mantener el rendimiento. Un inventario claro de VMs evita la proliferación descontrolada.

La virtualización también influye en la seguridad. El aislamiento limita el alcance de un fallo y permite sandboxing para analizar software con menos riesgo. Aun así, la configuración del hipervisor y las redes virtuales debe cuidarse para evitar accesos no deseados.

En el plano estratégico, la virtualización sienta la base del cloud computing. Los proveedores combinan hipervisores, redes y almacenamiento definidos por software para ofrecer recursos bajo demanda. Esa elasticidad y pago por uso resultan posibles gracias a este mismo principio de separación entre hardware y cargas.

la virtualización separa el “dónde” del “qué”. El “dónde” es el hardware físico; el “qué” son las instancias que corren encima. Al aislar y abstraer, se gana eficiencia, control y portabilidad sin convertir cada cambio en un proyecto complejo.

Si necesitas una regla práctica para situarla: usa máquinas virtuales cuando busques compatibilidad total y aislamiento fuerte, y valora contenedores cuando prime la ligereza y la rapidez. Entender estas piezas te permitirá elegir la herramienta adecuada sin entrar en detalles de instalación.

Tipos de virtualización y diferencias clave

La virtualización no es única: existen varias formas de “separar” software y hardware para lograr objetivos distintos. Aquí comparamos los tipos más comunes para que elijas con criterio.

La idea es sencilla: según lo que quieras aislar (un equipo entero, un escritorio, una app, la red o los datos), conviene una técnica u otra. Esta tabla resume qué abstrae cada una, cuándo usarla, su principal ganancia y en qué fijarte antes de adoptarla.

| Tipo | Qué abstrae | Cuándo usarla | Ventaja principal | Advertencia |

|---|---|---|---|---|

| Hardware/servidores (VM) | Un equipo completo: CPU, RAM, disco y dispositivos virtuales. | Consolidar servidores, ejecutar sistemas legados, entornos de prueba realistas. | Aislamiento fuerte y alta compatibilidad entre sistemas invitados. | Mayor consumo que opciones ligeras; requiere gestión del hipervisor. |

| Sistema operativo (contenedores) | Procesos que comparten kernel, con dependencias encapsuladas. | Despliegues rápidos, microservicios y alta densidad de cargas. | Arranque en segundos y excelente eficiencia de recursos. | Aislamiento menor que una VM; depende de políticas del sistema. |

| Aplicaciones | Runtimes y librerías específicos de una app. | Evitar conflictos de dependencias y simplificar distribución. | Portabilidad y menos “me funciona en mi equipo”. | Cubre la app, no todo el sistema; aislamiento limitado. |

| Escritorio (VDI) | Entornos de trabajo remotos administrados centralmente. | Teletrabajo, aulas, call centers y cumplimiento estricto. | Control total de imagen, datos y parches desde el centro de datos. | Depende de una red estable; puede requerir GPU y licencias. |

| Almacenamiento | Pools lógicos, volúmenes, snapshots y replicación. | Escalar capacidad, resiliencia y copias rápidas de datos. | Flexibilidad para crecer y proteger sin cambiar hardware. | Exige planificación de rendimiento y políticas de retención. |

| Red | Segmentación lógica, firewalls y balanceadores virtuales. | Microssegmentación, entornos multi-tenant y automatización. | Escalabilidad y control por software, sin depender del hardware físico. | Necesita diseño de políticas y observabilidad para evitar cuellos de botella. |

Si necesitas compatibilidad total y aislamiento fuerte, las VMs son apuesta segura. Si priorizas velocidad, densidad y despliegues frecuentes, los contenedores brillan. Para estandarizar puestos de trabajo, VDI facilita control y soporte.

Red y almacenamiento virtualizados completan el cuadro: permiten crecer, segmentar y proteger con agilidad. Como regla práctica, elige el tipo con el nivel de aislamiento justo y la menor complejidad posible para tu caso. Empezar simple y medir resultados evita sobrecostes y te da margen para ajustar después.

Casos de uso: dónde aporta valor la virtualización

La lista que sigue prioriza situaciones comunes donde la virtualización aporta valor real. El criterio es simple: qué problema resuelve, qué mejora concreta ofrece y qué debes tener en cuenta antes de aplicarla.

Piénsalo como un mapa rápido. Te ayuda a decidir si conviene usar máquinas virtuales, contenedores o escritorios remotos, y en qué medida.

- Consolidación de servidores: agrupa varios servicios en menos equipos físicos. Ahorra espacio, energía y mantenimiento. Planifica límites de CPU y memoria para evitar cuellos de botella.

- Pruebas y desarrollo: crea entornos desechables para experimentar sin tocar producción. Clona plantillas en minutos y vuelve atrás con un snapshot si algo falla. Facilita flujos de trabajo ordenados entre equipos.

- Recuperación ante desastres: replica sistemas a otro centro o nube. Si hay un corte, levantas las instancias desde la copia y reduces el tiempo de inactividad. Comprueba periódicamente que la restauración funciona.

- Escalado bajo demanda: cuando la carga sube, aprovisiona nuevas instancias y, cuando baja, retíralas. Pagas solo por lo que usas. Define umbrales claros para activar y desactivar recursos.

- Compatibilidad con software antiguo: ejecuta sistemas “legacy” sin depender de hardware ya descatalogado. Encierra ese software en una VM estable y controlada. Limita su acceso a red si no recibe parches.

- Seguridad y sandboxing: prueba archivos o apps de origen dudoso en un entorno aislado. Si hay problema, lo eliminas sin afectar al resto. Útil para análisis, formación y respuesta a incidentes.

- VDI y aulas remotas: ofrece escritorios centralizados accesibles desde casa o la oficina. Facilita actualizaciones y control de datos. Calcula bien el ancho de banda para una buena experiencia.

- Optimización de costes: sube la utilización del hardware y apaga lo que no se usa. Reduce compras urgentes y gastos de soporte. Acompáñalo de métricas para demostrar el ahorro.

- Formación técnica y demostraciones: entrega a cada alumno o cliente un entorno igual al tuyo. Evitas “en mi equipo funciona” y estandarizas el aprendizaje. Define tiempos de vida para no acumular instancias olvidadas.

Estos casos cubren productividad, continuidad del negocio y control de riesgos. Elige el tipo de virtualización según el nivel de aislamiento que necesites, el rendimiento esperado y tu presupuesto. Empieza por un piloto pequeño, mide resultados y expándelo solo donde aporte beneficios claros.

Componentes y arquitectura: hipervisor, VMs y contenedores

Para entender la arquitectura de la virtualización conviene imaginar capas. Cada capa cumple una función y todas cooperan para ofrecer entornos aislados y manejables. La meta es clara: ejecutar más servicios con menos hardware, manteniendo control, aislamiento y buen rendimiento.

En la base está el hardware: procesadores con extensiones de virtualización, memoria, discos y tarjetas de red. Estas piezas ofrecen la potencia real. Sobre ellas se construye una capa que traduce y reparte esos recursos entre varias instancias.

El papel del hipervisor

La pieza central es el hipervisor. Este software asigna CPU, memoria, red y almacenamiento a cada entorno virtual y evita interferencias. Actúa como árbitro: decide quién usa qué y durante cuánto tiempo, sin que unas cargas “pisen” a otras.

Hay dos enfoques. Los hipervisores tipo 1 se instalan directamente sobre el hardware (bare metal). Ofrecen mayor eficiencia y seguridad, por eso dominan en centros de datos. Los hipervisores tipo 2 se ejecutan como una aplicación en un sistema operativo anfitrión. Son prácticos para portátiles, demostraciones y laboratorios.

Máquinas virtuales: sistemas completos

Las máquinas virtuales (VM) son entornos completos con su propio sistema operativo invitado. Dentro de cada VM se instalan aplicaciones como si fuesen equipos físicos. El hipervisor les presenta dispositivos virtuales homogéneos, lo que simplifica el movimiento entre servidores.

Para ganar velocidad, muchas VMs usan paravirtualización: controladores optimizados que hablan “el idioma” del hipervisor, sobre todo en red y almacenamiento. Así se reduce la sobrecarga y se acerca el rendimiento al de un servidor físico.

Además, las VMs cuentan con utilidades clave. Las imágenes permiten clonar configuraciones base. Los snapshots capturan un punto en el tiempo para volver atrás si algo falla. Estas funciones aceleran pruebas, actualizaciones y recuperación ante incidentes.

Contenedores: ligereza y rapidez

Los contenedores aíslan procesos, pero comparten el núcleo del sistema operativo anfitrión. Arrancan en segundos, consumen menos memoria y se replican con facilidad. Por eso son atractivos para microservicios y despliegues frecuentes.

El intercambio es claro: se gana densidad y velocidad, pero el aislamiento depende más de mecanismos del sistema operativo. Las VMs, al incluir su propio núcleo, ofrecen un cerco más fuerte y compatibilidad total con sistemas invitados muy distintos.

Red y almacenamiento virtual

Sobre el hipervisor viven componentes de red virtual, como switches y adaptadores virtuales, que conectan VMs y contenedores sin necesidad de cablear físicamente. Esto facilita segmentar entornos, aplicar políticas y mover cargas de un host a otro sin cortar el servicio.

En almacenamiento, los volúmenes virtuales permiten snapshots, cifrado y aprovisionamiento flexible. El objetivo es dar a cada instancia el espacio que necesita, con resiliencia y sin atarla a un único disco físico.

Gestión y alta disponibilidad

Encima de todo aparecen las herramientas de gestión y orquestación. Automatizan despliegues, asignación de recursos y políticas de seguridad. También coordinan la alta disponibilidad: si un host falla, las cargas se reinician en otro, reduciendo el tiempo de inactividad.

En conjunto, esta arquitectura separa lo físico de lo lógico. El hipervisor y sus servicios sostienen VMs y contenedores, mientras la red y el almacenamiento virtual proporcionan conectividad y datos flexibles. El resultado es una base sólida para crecer, proteger y optimizar servicios sin rehacer el hardware cada vez.

Ventajas y limitaciones: rendimiento, costes y gestión

La virtualización aporta un equilibrio entre flexibilidad y control. Permite ejecutar varias cargas en el mismo hardware y ajustar recursos según la demanda. El resultado suele ser una infraestructura más ordenada y fácil de ampliar.

En eficiencia, brilla por la consolidación: menos máquinas físicas y mejor uso de CPU, memoria y almacenamiento. Además, el aprovisionamiento ágil reduce esperas: crear, clonar o retirar instancias lleva minutos en lugar de días.

Para equipos de TI, el mayor valor es la estandarización. Plantillas, imágenes y políticas comunes simplifican la vida útil de los servicios. Esto acelera pruebas, despliegues y recuperaciones ante fallos, sin recetas complejas.

En operaciones, centralizar copias, parches y monitoreo disminuye errores. También facilita programar mantenimientos sin parar servicios, moviendo VMs entre hosts con mínima interrupción.

El capítulo del rendimiento requiere matices. La capa de virtualización añade un coste extra, conocido como overhead. Con cargas típicas de negocio (web, bases de datos moderadas, apps internas) suele ser pequeño. En trabajos sensibles a la latencia o muy intensivos en E/S, ese impacto puede notarse más.

El papel del hipervisor es clave. Soluciones modernas aprovechan aceleración por hardware y control fino de memoria y CPU. Cuando procede, la paravirtualización mejora el acceso a red y disco, reduciendo cuellos de botella sin cambiar la aplicación.

Un ejemplo práctico: una tienda en línea puede alojar servidor web, caché y base de datos en VMs separadas. Cada una escala según su carga, sin interferirse. En horas pico, se añaden instancias; en horas valle, se retiran para ahorrar recursos.

Otra ganancia clara es la resiliencia. Funciones como snapshots y replicación permiten volver atrás tras un error o recuperar servicios en otro host. Esta agilidad reduce tiempos de inactividad y evita pérdidas mayores.

En costes, hay dos caras. Se reduce el gasto en hardware y espacio físico, y baja el consumo eléctrico al aumentar la densidad. A cambio, aparecen licencias de plataforma, almacenamiento compartido más capaz y herramientas de gestión. La balanza suele ser favorable si se controla el crecimiento y se automatizan tareas repetitivas.

La gestión también cambia. Surgen redes virtuales, plantillas y políticas de acceso que hay que gobernar con rigor. Con inventario actualizado y etiquetado consistente, localizar y mantener instancias resulta más simple. Sin ese orden, el entorno se descontrola.

Aquí entra el riesgo de sprawl: proliferación de VMs y contenedores que nadie usa, pero consumen recursos y licencias. La solución pasa por ciclos de vida claros, caducidad automática y revisiones periódicas. Medir uso real ayuda a decidir qué cerrar y qué optimizar.

Otro límite es el aislamiento. Es robusto, pero no absoluto. Configuraciones débiles de red virtual o permisos excesivos abren puertas laterales. Controles básicos —segmentación, autenticación multifactor en consolas y cifrado— mantienen la superficie de ataque bajo control.

Las cargas “exigentes” marcan la frontera natural. Bases de datos de muy baja latencia, procesamiento científico o tarjetas GPU al límite pueden requerir ajustes finos o incluso hardware dedicado. Aun así, muchas de estas cargas obtienen buen desempeño con asignación correcta de CPU pinning, almacenamiento rápido y colas de E/S modernas.

La experiencia de usuario importa. Si el escritorio remoto o VDI sufre por una red saturada, la percepción del sistema cae. Planificar ancho de banda, cachés locales y perfiles de usuario ligeros evita ese desgaste.

La decisión final se toma con datos. Métricas de rendimiento, costes totales y riesgo operativo permiten comparar escenarios: todo virtualizado, enfoque híbrido o cargas críticas en físico. Ajustar el tipo de virtualización a cada servicio suele ofrecer el mejor retorno.

las ventajas se concentran en agilidad, estandarización y ahorro estructural. Las limitaciones se controlan con buen diseño, gobierno del inventario y medición continua. Cuando la plataforma se gestiona con reglas simples y visibles, la virtualización rinde al máximo sin sorpresas.

Seguridad, aislamiento y cumplimiento en entornos virtualizados

El pilar de la seguridad en entornos virtualizados es el aislamiento. Cada máquina o contenedor funciona como un “compartimento” separado, de modo que un fallo o infección en una instancia no afecta a las demás. Este principio permite probar cambios, contener amenazas y limitar el alcance de errores.

Los hipervisores añaden controles para separar memoria, disco y dispositivos virtuales. Cuando están bien configurados, impiden accesos no autorizados entre instancias y reducen el riesgo de fugas. Aun así, su consola de administración es crítica: debe estar protegida con autenticación fuerte, roles mínimos y acceso solo desde redes confiables.

Para ejecutar software de origen dudoso, el sandboxing es una barrera útil: se crea un entorno desechable, se evalúa el comportamiento y, si algo sale mal, se elimina sin afectar al resto. Este enfoque también es práctico para formación, pruebas rápidas y análisis de archivos sospechosos.

En cumplimiento, segmentar datos y cargas sensibles en VMs o contenedores dedicados facilita auditorías, registros claros y controles diferenciados. Ayuda a aplicar el principio de mínimo privilegio, cifrar datos en tránsito y en reposo, y separar entornos de desarrollo, pruebas y producción para evitar cruces indeseados.

Persisten desafíos: errores de configuración en redes virtuales, exceso de permisos, imágenes desactualizadas o proliferación de instancias sin control. Para mitigarlos, conviene mantener parches al día, endurecer configuraciones, usar microsegmentación, registrar y supervisar accesos, y ensayar copias de seguridad y planes de recuperación. Con una política clara y vigilancia continua, la virtualización aporta seguridad sin frenar la operativa.

Glosario esencial y términos relacionados en virtualización

Este glosario te sirve para entender las palabras clave de virtualización sin enredos. Cada término explica qué es, por qué importa y cuándo usarlo en decisiones de TI, formación o evaluación de propuestas.

Lee las definiciones de forma lineal o salta al concepto que necesites. La idea es darte claridad práctica y un lenguaje común para hablar con equipos técnicos y proveedores.

- Hipervisor: software que reparte CPU, memoria y dispositivos entre instancias separadas. Es el árbitro que garantiza estabilidad y seguridad. Úsalo como criterio central al elegir plataforma de virtualización.

- Máquina virtual (VM): “equipo” completo que corre como invitado. Incluye su propio sistema operativo y apps. Ideal para compatibilidad, aislamiento fuerte y cargas que exigen entornos estables.

- Contenedores: procesos aislados que comparten el kernel del anfitrión. Arrancan rápido y consumen menos recursos. Opta por ellos para desplegar aplicaciones modernas y microservicios con alta densidad.

- Paravirtualización: optimización que ofrece interfaces adaptadas a entornos virtuales. Reduce la sobrecarga en red y disco. Actívala cuando busques mejorar rendimiento sin cambiar la arquitectura base.

- Snapshot: captura del estado de una VM o volumen en un momento concreto. Permite volver atrás tras una prueba o actualización. Úsalo con disciplina y borra los antiguos para evitar consumo de espacio.

- Imagen: plantilla reutilizable para crear VMs o contenedores de forma uniforme. Acelera despliegues y asegura consistencia. Mantén un catálogo curado y con versiones etiquetadas.

- VDI (virtualización de escritorio): escritorios remotos entregados desde el centro de datos o la nube. Facilita soporte, control y teletrabajo. Requiere buena conectividad y políticas claras de perfiles y datos.

- Virtualización de red: crea redes lógicas, cortafuegos y balanceadores en software. Segmenta, automatiza y escala sin depender del hardware físico. Define reglas simples y aplica microsegmentación desde el inicio.

- Virtualización de almacenamiento: agrupa discos en pools y expone volúmenes lógicos. Habilita snapshots, réplicas y thin provisioning. Elige niveles de rendimiento y resiliencia según cada carga.

- Orquestación: automatiza creación, actualización y retirada de VMs o contenedores. Aplica políticas de red, seguridad y escalado de forma coherente. Empieza con plantillas estandarizadas y CI/CD para cambios seguros.

- Aislamiento: separación entre instancias para evitar interferencias y limitar daños. Es clave para seguridad y pruebas. Ajusta el nivel según el riesgo: VM para separación fuerte, contenedor para velocidad.

- Overhead: coste extra de rendimiento por añadir la capa de virtualización. Suele ser bajo si la plataforma está bien ajustada. Mídelo con métricas reales y optimiza E/S y red antes de escalar hardware.

Con estos conceptos tendrás un mapa claro para comparar opciones y hablar con precisión. Si necesitas ampliar, revisa documentación oficial de tus plataformas y prioriza métricas de rendimiento, seguridad y coste total para tomar decisiones informadas.

Tendencias: virtualización, cloud computing y contenedores

La base del cloud computing es la virtualización. Los centros de datos crean muchos entornos lógicos sobre pocas máquinas físicas, y con eso ofrecen capacidad bajo demanda. Esa elasticidad permite pagar solo por lo que se usa y mover cargas entre regiones sin interrumpir el servicio.

En paralelo, los contenedores han ganado protagonismo. Encapsulan aplicaciones y sus dependencias en paquetes ligeros, fáciles de iniciar, detener y replicar. No sustituyen a las máquinas virtuales en todo, pero complementan muy bien cuando importa la rapidez.

VMs y contenedores: un equilibrio práctico

Las VMs brindan aislamiento fuerte y compatibilidad con sistemas operativos completos, incluso antiguos. Son preferibles para cargas críticas, software legado o cuando se requiere una “caja” totalmente separada por motivos de seguridad o cumplimiento.

Los contenedores brillan en despliegues frecuentes y escalado fino. Si se necesita arrancar decenas de instancias en segundos para absorber picos, su ligereza marca la diferencia. La tendencia real es híbrida: usar cada tecnología donde aporta más valor.

Arquitecturas modernas y portabilidad

Los equipos descomponen aplicaciones en servicios pequeños y bien definidos. Esta idea, a menudo asociada a microservicios, encaja con contenedores y con redes virtuales que conectan piezas de forma controlada. El objetivo es publicar cambios rápidos sin afectar al conjunto.

Para evitar dependencias rígidas, se busca portabilidad. Plantillas de VMs, imágenes de contenedor y estándares abiertos facilitan mover cargas entre nubes y centros de datos propios. Esa movilidad reduce riesgos de bloqueo con un único proveedor.

Edge y ubicuidad del cómputo

La virtualización también sale del centro de datos. En el borde de la red, cerca del usuario o del sensor, se ejecutan funciones empaquetadas como VMs ligeras o contenedores. Esto acorta la latencia para análisis de vídeo, control industrial o contenido en streaming.

La idea es la misma: aislar tareas, asignar recursos y actualizar sin parar el servicio. Cambia el tamaño del equipo y la red disponible, pero no los principios básicos.

Rendimiento acelerado y nuevas arquitecturas

Las cargas con mucha demanda de cómputo, como IA o gráficos 3D, impulsan la virtualización de GPU y el uso de procesadores especializados. Los hipervisores y las plataformas de contenedores aprenden a compartir estos aceleradores sin perder demasiada eficiencia.

También crece el interés por arquitecturas de bajo consumo. Ejecutar VMs y contenedores en procesadores eficientes ayuda a contener costes energéticos y a escalar con más densidad por host.

Automatización, coste y sostenibilidad

Escalar sin caos exige automatización. Políticas que crean, actualizan y retiran instancias reducen errores y tiempo manual. El resultado es más consistencia y menos interrupciones.

La otra cara es el control del gasto. Medir uso real, ajustar tamaños y apagar lo que no se necesita se vuelve clave. La virtualización permite hacerlo, pero requiere disciplina y métricas claras.

Seguridad y confianza

Los proveedores fortalecen el aislamiento con controles de memoria, arranque verificado y cifrado por defecto. En nubes públicas y privadas, crece el interés por proteger datos incluso cuando el operador gestiona la infraestructura.

Aun con avances, la regla práctica se mantiene: segmentar adecuadamente, limitar permisos y vigilar las superficies de gestión. Virtualizar no elimina riesgos; los organiza y permite aplicar barreras más finas.

En conjunto, virtualización, cloud computing y contenedores convergen en una meta común: entregar software rápido, seguro y a coste razonable. Elegir la pieza correcta para cada carga —VM, contenedor o una mezcla de ambos— es la tendencia que guía las decisiones bien informadas.